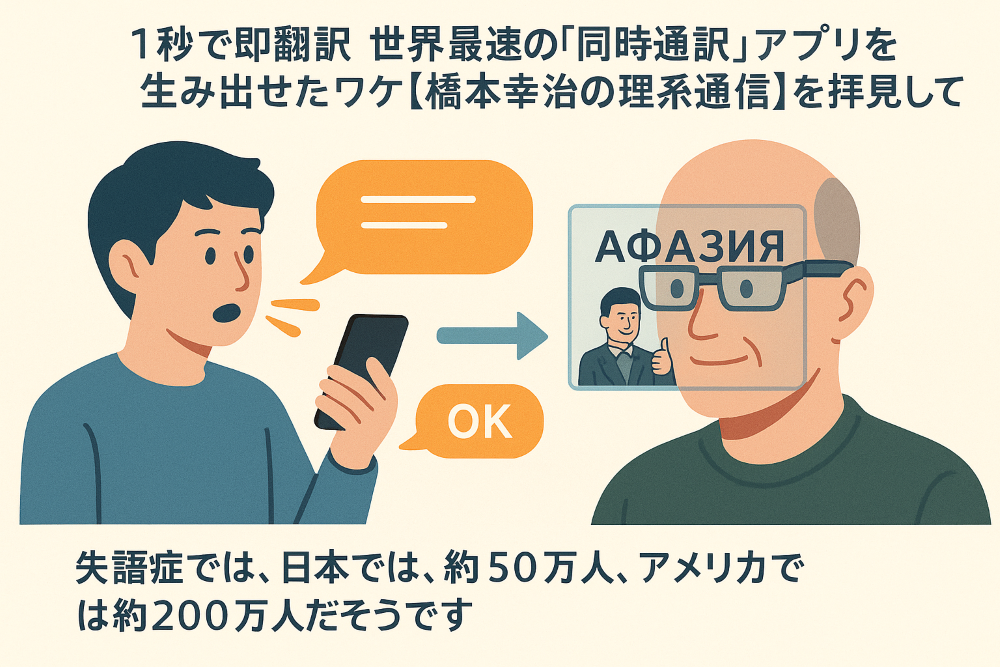

私は、YouTubeで「1秒で即翻訳 世界最速の『同時通訳』アプリを生み出せたワケ【橋本幸治の理系通信】」を拝見しました。

https://www.youtube.com/watch?v=wk1pVcRrenk

この動画は、日本発のAI翻訳アプリが、世界最速レベルの同時通訳を実現した背景を、サイエンス的に解説してくれています。

実は私自身、失語症という言語障害を抱えており、「聞く」「話す」「理解する」ことに困難があるため、これまでに特許を5件作成し、特許庁へ提出しました。

今回のYouTubeを見ながら、自分が目指してきた技術と驚くほど重なる点があり、深く感動しました。

私が提出した特許の仕組みは、以下の流れです。

- 他者から音声で届いた内容を

- リアルタイムで文字化し、

- 短く翻訳して、

- イラストもつけてわかりやすくし、

- メガネ型デバイスで表示する

つまり、重要なのは、(1)長い文章を短くまとめ、(2)イラストを追加して視覚的に補い、(3)メガネ型デバイスに出力することです。

私は、「言葉の壁」を時間差なく、直感的に超える技術を追求してきました。

この目標は、今回紹介された「同時通訳アプリ」と非常に近い方向性を持っています。

失語症について少し補足します

失語症は、脳の損傷などにより言葉に関する機能が障害される病気です。

日本では約50万人、アメリカでは約200万人が失語症を抱えていると言われています。

有名な例では、俳優のブルース・ウィリス氏も失語症を公表し、引退を余儀なくされたことで、世界中で注目されました。

言葉を失うということは、単に「話せない」だけではなく、社会とのつながりを持つ力が大きく制限されることでもあります。

だからこそ、こうした即時翻訳・即時理解の技術には、非常に大きな可能性があると私は考えています。

なぜ世界最速を実現できたのか?

この動画で解説されていたポイントは、End-to-Endモデルにありました。

通常、

音声認識 → 翻訳 → 音声出力

というステップを別々に行うと、それぞれに時間がかかり、合計で数秒以上の遅延が発生します。

しかし、End-to-Endモデルでは、音声をそのまま一気に翻訳まで処理します。

そのため、発話してから翻訳されるまでの平均遅延は1秒以下。

これは人間の通訳者に近いスピードだと言われています。

さらに、Kotoba Technologiesは、小型で省エネなモデル設計に成功したため、iPhone単体でも超高速処理を実現できたそうです。

私が学んだこと

この動画を見て、改めて次の3つの学びを得ました。

- **「聞く→理解する→伝える」**の連続プロセスを、最短距離で結ぶことが重要

- ハイスペックなサーバーよりも、省エネ設計と効率化が大事

- 日本発でも、グローバル基準の技術を生み出せる

特に失語症の私にとって、「即座に、わかりやすく伝える」ことは生活そのものに直結しています。

今回紹介された技術は、失語症や高次脳機能障害を持つ方々にとっても、大きな希望になると感じました。

さらに発展できる特許アイデア

今回学んだ内容をもとに、次のような新しい特許アイデアも考えました。

🔹 感情認識型同時通訳システム

- 音声だけでなく、話者の**感情(喜び・怒り・悲しみなど)**も自動検出し、

- 翻訳文やイラストのトーンを合わせて表示する。

🔹 会話の流れ補完システム

- 話の文脈(テーマや質問)を自動で推定し、

- 次に予測される会話文を先読み翻訳して待機する。

🔹 個人適応型メガネディスプレイ

- ユーザーの認知特性(例えば「絵が得意」「文字が得意」など)に合わせて、

- 表示する情報の形式や量をカスタマイズする。

これらを組み合わせることで、失語症の方、外国語に不安のある方、さらには高齢者まで、より自由で豊かなコミュニケーション世界が広がるでしょう。

まとめ

AI技術の進歩は、「健康な人だけ」のためではありません。

障害のある人も、年齢を重ねた人も、誰もが対等に情報を受け取り、伝えられる社会を作る力を持っています。

今回のYouTubeは、その未来への「小さな確かな一歩」だと強く感じました。

そして、私自身も引き続き、自分の経験を活かした発明や特許活動を続けていきたいと思います。

コメント